上海交大严骏驰副教授课题组研究成果获评AAAI21最具影响力论文

近日,电子信息与电气工程学院人工智能研究院/计算机系的严骏驰副教授和其博士生杨学(交大学术之星提名获得者)的研究成果《R3Det: Refined Single-Stage Detector with Feature Refinement for Rotating Object》位居paper Digest网站评选的AAAI21最具影响力论文榜首。

该研究提出一个有向目标检测网络—R3Det,有效地解决了定位多角度物体及将物体从背景准确、快速分离的问题,能够很好地运用在文本检测和遥感目标检测任务中。

AAAI

AAAI (The AAAI Conference on Artificial Intelligence) 是人工智能领域顶级国际学术会议之一(2021年录用率为21.4%,1692/7911)。paper Digest是由东京工业大学的研究人员在2018年开发的一个基于人工智能技术的学术文章摘要服务网站,维护着世界上最大的科技知识图谱之一。paper Digest团队分析了近三年来在AAAI上发表的所有论文,并给出每年最具影响力的15篇论文列表,该列表根据研究论文和授权专利的引用自动构建,并且经常更新以反映最新的变化,是目前最具权威性的榜单之一。

研究概况

目标检测是计算机视觉中的基本任务之一,有向目标检测是指对给定图像进行准确目标定位并进行类型识别的任务,常用于车站/机场/博物馆等场景的安检和人脸身份验证识别、卡证/文档上的文字自动提取与识别,以及汽车、行人、交通指示牌等无人驾驶场景要素的检测与识别等。然而,由于现实场景复杂多变,往往难以定位多角度目标,有向目标检测一直是一项极具挑战性的任务。该研究从大长宽比、密集排列和尺度变化剧烈的目标入手,提出了一种端到端的级联有向目标检测器—称之为RefinedRotated RetinaNet Detector(R3Det)。R3Det通过从粗到细的渐进回归方式来快速准确地检测目标,并集成了一个特征精修模块来获取更准确的特征以提高目标检测性能。

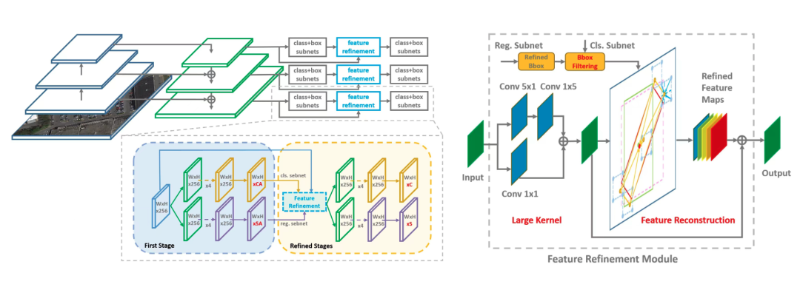

左:R3Det结构图;右:特征精修模块

以上示意图展示了R3Det的整体结构图以及特征精修模块的核心是通过逐像素特征插值将当前精修边界框的位置信息重新编码到对应的特征点,实现特征重构和对齐。

有向目标检测网络的提出,为解决有向目标检测中特征不对齐问题提供了创新性思路和方法,研究团队已在三个遥感数据集DOTA、HRSC2016、UCAS-AOD以及一个场景文本数据集ICDAR2015上验证了所提方法的有效性。在此基础上,未来可将其应用到人脸识别、航拍图像、医学图像、自动驾驶等场景中,进行更精确的有向目标检测与分析。

遥感图像上的检测效果展示,R3Det可以精准定位机场中方向各异的飞机位置

课题组研究进展

近三年来,严骏驰副教授的课题组已经连续在人工智能顶级会议ICCV19、ECCV20、AAAI21、CVpR21、ICML21、NeurIpS21、IJCV22上发表系列有向视觉目标检测论文。同时,课题组已发布两个有向目标检测开源框架MMRotate和AlphaRotate,成为有向目标检测领域最受欢迎的开源框架,所开源代码在Github开源社区累计star超过4000次。

论文链接

论文原文:https://ojs.aaai.org/index.php/AAAI/article/view/16426

paperDigest:https://www.paperdigest.org/2022/02/most-influential-aaai-papers-2022-02/

MMRotate:https://github.com/open-mmlab/mmrotate

AlphaRotate:https://github.com/yangxue0827/RotationDetection

Demo:https://yangxue0827.github.io/#demos

电子信息与电气工程学院 电子信息与电气工程学院