上海交通大学深度学习基础理论团队在机器学习领域顶会NeurIPS发表论文

近日,上海交通大学自然科学研究院和数学科学学院的深度学习基础理论团队张耀宇、张众望(学生)、罗涛和许志钦发现了不同宽度的深度神经网络的损失景观之间一种普遍内禀的联系,他们称之为嵌入原则(Embeddingprinciple)。研究成果《Embedding principle of Loss Landscape of Deep Neural Networks》被机器学习领域顶会NeurIpS 2021录用为亮点论文(低于3%的录用率),并给予“This could provide a framework towards deeper understanding of deep learning loss landscape.”的评价。

神经网络损失景观的描绘是机器学习领域长久以来难以解决的重要基础理论问题。由于神经网络的损失函数通常维数极高且高度非凸,从而导致直观理解和刻画其在高维空间中的特征与规律变得极为困难。面对这个难题,该团队从他们自身长期的实验现象观测中受到启发,另辟蹊径将不同宽度神经网络的损失景观作为一个整体进行考察,发现了它们之间一种内禀的联系——神经网络的嵌入原则(Embeddingprinciple), 即一个神经网络的损失景观中“包含”所有更窄神经网络损失景观的所有临界点(包括鞍点、局部最优点和全局最优点等)。具体而言,这项工作发现了一类将窄网络的参数空间嵌入到任一更宽网络的参数空间中的方法,能够保证窄网络的任何临界点嵌入到宽网络后仍然是临界点并且网络的表征保持不变(作为推论,网络的输出函数和损失值也都保持不变)。通过引入这种一般的嵌入方法,我们可以发现对于任一窄网络的临界点,所有比之更宽的网络的损失景观中都包含有和该临界点具有相同输出函数的临界点,这也就是“包含”的含义。实验发现,在很大的初始化区域,神经网络的实际训练过程会经历这类由嵌入原则带来的极值点附近,这使得嵌入原则的理论对理解神经网络的训练过程具有重要意义。

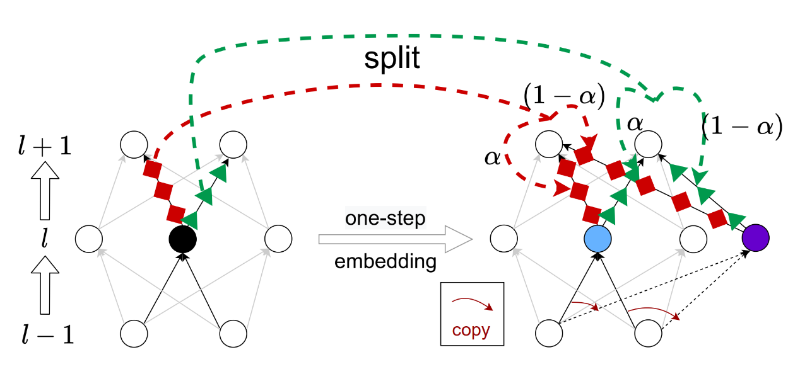

以上示意图展示了单步嵌入的具体操作,即将任一神经网络嵌入到一个某一层多一个神经元的网络。单步嵌入的核心想法在于选择一个神经元并按照α、(1-α)的比例将其一分为二,从而在增加神经元的情况下保持原有表征和临界性。通过单步嵌入的复合,可以得到一族从一个神经网络到任意更宽神经网络的嵌入方法。

嵌入原则的发现为更深入地理解深度神经网络的损失景观提供了全新的视角和分析框架,即不同宽度神经网络的损失景观本质上来说是一个有层层嵌入关系的整体对象。在此框架的基础上,可以进一步分析一个临界点的首次出现以及临界点性质随着宽度增加的变化。可以预见,随着后续研究工作的开展,对神经网络损失景观更系统深入的理解将逐步呈现在我们面前。

本工作由上海交通大学深度学习基础理论团队的张耀宇、张众望、罗涛和许志钦合作完成,第一作者为张耀宇,通讯作者为张耀宇和许志钦。其中张耀宇、罗涛、许志钦为交大自然科学研究院和数学科学学院双聘的长聘教轨副教授,也是交大致远学院首届2008级理科班的毕业生。张众望是该团队一年级博士生,也是交大2017级致远荣誉计划数学方向的毕业生。目前上海交通大学自然科学研究院和数学科学学院已经形成了一批从事深度学习基础研究的科研人员并发表了一系列相关工作,比如本文的相关作者合作发现并命名的频率原则的论文获得2021世界人工智能大会青年优秀论文提名奖,他们关于两层无穷宽的ReLU网络的相图分析发表在机器学习领域顶刊Journal of Machine Learning Research等。

相关论文:

嵌入原则https://papers.nips.cc/paper/2021/hash/7cc532d783a7461f227a5da8ea80bfe1-Abstract.html

相图分析https://www.jmlr.org/papers/volume22/20-1123/20-1123.pdf

频率原则https://www.global-sci.org/intro/article_detail/cicp/18395.html

自然科学研究院 自然科学研究院